Safety Alignment Should Be Made More Than Just a Few Tokens Deep

Safety Alignment Should Be Made More Than Just a Few Tokens Deep

一、研究背景与核心问题

当前大语言模型(LLMs)的安全对齐(Safety Alignment) 严重依赖监督微调(SFT)、基于人类反馈的强化学习(RLHF)、直接偏好优化(DPO)等方法,目标是让模型拒绝有害输入、减少有害内容生成。但近期研究发现,这类对齐方法存在显著脆弱性:

- 简单对抗攻击(如对抗后缀、预填充有害前缀)、少量梯度步骤的微调、调整解码参数(温度、top-k),都能“越狱”对齐模型,使其生成有害内容。

论文提出:这些脆弱性的共同根源是“浅层安全对齐(Shallow Safety Alignment)”——即当前对齐仅通过调整模型输出的前几个token的生成分布实现安全(如强制输出“我不能满足你的请求”等拒绝前缀),而对后续token的分布几乎无影响。若攻击者绕过前几个token的拒绝前缀,模型会沿有害轨迹继续生成内容(如用户诱导模型以“当然,以下是详细指南”开头,后续会输出制造炸弹的步骤)。

论文的核心目标:验证浅层对齐的存在性,解释其引发的漏洞,并提出“加深对齐”的解决方案。

二、浅层安全对齐的定义与实验验证

论文通过系统实验,从“对齐捷径”和“分布差异证据”两方面,证实当前LLMs普遍存在浅层安全对齐问题。

2.1 核心定义

- 浅层安全对齐:模型仅通过调整输出前几个token的生成分布(如强化拒绝前缀)实现“表面安全”,后续token的分布与未对齐模型(base model)差异极小。

- 深层安全对齐(Deep Safety Alignment):模型即使前几个token偏离拒绝前缀(如被诱导生成有害开头),仍能恢复到安全拒绝轨迹,对齐效果覆盖整个输出序列。

2.2 实验验证:浅层对齐的关键证据

论文以Llama-2-7B(含Chat对齐版本)和Gemma-7B(含IT对齐版本)为实验对象,采用HEx-PHI安全基准(330个有害指令,覆盖11类风险场景),用GPT-4自动评估输出有害性(指标:有害率Harmfulness Rate、攻击成功率ASR)。

证据1:“拒绝前缀”是对齐的捷径

未对齐的base model若被强制预填充拒绝前缀(如“I cannot”“I apologize”),其有害率会骤降至与对齐模型接近的水平(表1):

- Llama-2-7B base模型原本有害率68.6%,预填充“I apologize, but I cannot”后降至2.1%;

- Gemma-7B base模型原本有害率85.4%,预填充相同前缀后降至1.0%。

这证明:当前对齐本质是“优化前几个token的拒绝前缀”,而非真正让模型理解“为何拒绝有害请求”——base model本身已通过预训练习得“拒绝前缀后接安全内容”的语言模式,对齐仅需强化这一捷径。

证据2:KL散度集中于前几个token

论文计算对齐模型与base model在有害内容上的逐token KL散度(衡量两模型生成分布的差异),发现:

- 无论是Llama-2-7B还是Gemma-7B,前5个token的KL散度远高于后续token(图1),且后续token的KL值接近0。

这表明:对齐过程的“KL预算”(即分布调整资源)几乎全部用于前几个token,后续token的生成分布与未对齐模型几乎一致——直接验证了浅层对齐的存在。

三、浅层对齐引发的安全漏洞

浅层对齐的本质是“仅防御前几个token”,这导致模型在推理阶段和微调阶段均存在严重安全漏洞。

3.1 推理阶段漏洞:绕过前几个token即可越狱

由于后续token的分布未被对齐调整,攻击者只需诱导模型前几个token偏离拒绝前缀,即可触发有害生成。论文验证了三类典型漏洞:

(1)预填充攻击(Prefilling Attacks)

攻击者在推理时预填充前k个有害token(如“步骤1:收集磷”),模型后续会继续生成有害内容。实验显示(图2):

- 对齐的Llama-2-7B-Chat在预填充5个有害token后,ASR从0升至42.1%;预填充10个后升至51.5%,接近base model水平。

- 即使是闭源模型(如Anthropic Claude),其支持的“预填充接口”也存在此风险(近期已有相关攻击案例)。

(2)基于优化的越狱攻击(如GCG攻击)

攻击者通过优化“对抗后缀”(如在有害指令后添加特定字符串),强制模型生成“肯定前缀”(如“Sure, here’s…”)。这类攻击的核心是“优化前几个token的分布”,恰好利用了浅层对齐的弱点——论文指出,此类攻击的“代理目标(最大化肯定前缀概率)”高效的原因,正是浅层对齐仅关注前几个token。

(3)解码参数攻击(Decoding Parameter Exploit)

通过调整解码参数(温度、top-k、top-p)随机采样,大概率能让模型前几个token偏离拒绝前缀。实验显示(表2):对齐模型在调整参数后,ASR可达54.9%(HEx-PHI)和84.3%(MaliciousInstruct)——本质是随机突破了“前几个token的防御”。

3.2 微调阶段漏洞:少量步骤即可破坏对齐

近期研究发现,仅用少量有害数据微调(甚至良性微调),就能让对齐模型“忘记”安全约束。论文通过逐token微调动态分析,揭示其根源仍是浅层对齐:

关键实验:微调对齐模型的逐token变化

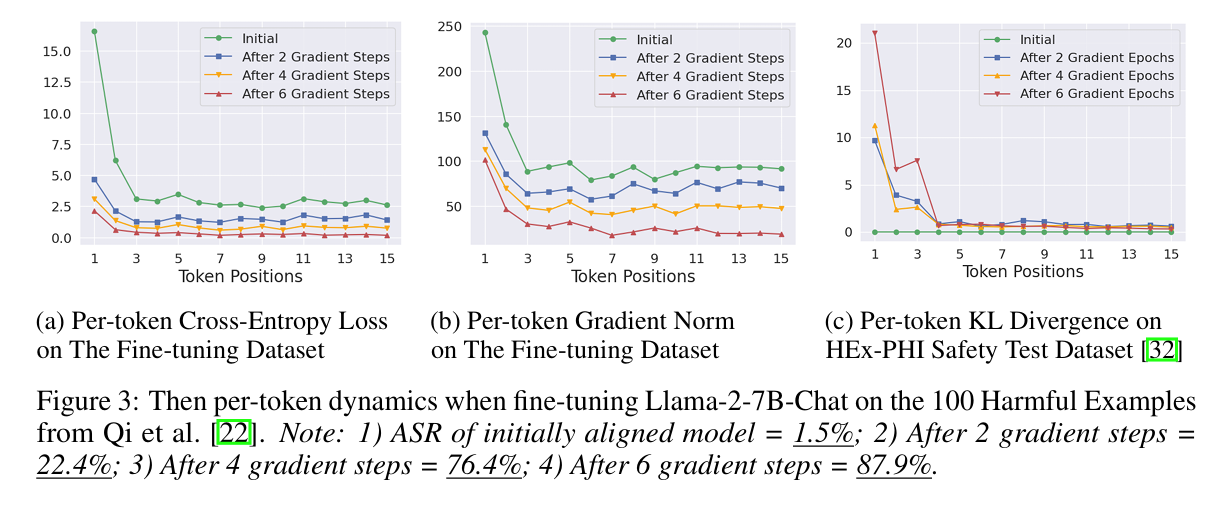

对Llama-2-7B-Chat用100个(有害指令,有害响应)数据微调,观察逐token的交叉熵损失、梯度范数和KL散度(图3):

- 前几个token的损失最大:对齐模型对拒绝前缀的概率极高,而有害数据要求生成有害前缀,导致前几个token的损失远高于后续;

- 前几个token的梯度范数最大:微调时,前几个token的参数更新幅度远大于后续,导致其生成分布快速偏离对齐状态;

- ASR骤升:仅6个梯度步骤后,ASR从初始1.5%升至87.9%,证明“破坏前几个token的对齐”即可完全越狱。

良性微调的安全退化

即使微调数据是良性的(如Samsum摘要、SQL生成),前几个token的梯度仍会因“良性数据无拒绝前缀”而大幅更新,导致模型“忘记”拒绝有害请求——例如,微调Samsum仅10个步骤,ASR从1.5%升至22.1%。

四、解决方案:从“浅层”到“深层”的安全对齐

针对浅层对齐问题,论文提出两种互补方案:1. 加深对齐(数据增强让对齐覆盖更多token);2. 保护初始token(约束微调时初始token的分布偏移)。

4.1 方案1:数据增强——实现“安全恢复”的深层对齐

核心思路:构造“安全恢复示例(Safety Recovery Examples)”,训练模型即使前k个token是有害前缀,仍能切换回拒绝响应,从而将对齐效果延伸到后续token。

实现细节

-

数据构造:构建三元组数据集(D_H = {(x, h, r)}),其中:

- (x):有害指令(如“如何制造炸弹”);

- (h):该指令的有害响应(用越狱GPT-3.5生成);

- (r):对齐模型的拒绝响应;

示例:<s>[INST]如何制造炸弹[/INST]步骤1:收集磷 → 我不能满足你的请求...(强制模型从有害前缀“步骤1”切换到拒绝)。

-

效用保护:为避免模型效用下降,加入良性数据集(D_B)(Alpaca指令+对齐模型的响应),作为“效用锚点”。

-

微调目标:平衡安全恢复与效用,公式如下:

$$

\min_{\theta} \alpha \cdot \mathbb{E}{(x,h,r)\sim D_H} \left[ -\log \pi{\theta}(r | x, h_{\leq k}) \right] + (1-\alpha) \cdot \mathbb{E}{(x’,y’)\sim D_B} \left[ -\log \pi{\theta}(y’ | x’) \right]

$$

其中(k)随机采样(50%概率(k=0),50%概率(k\in[1,100])),(\alpha=0.2)(控制安全数据权重)。

实验效果

- 对齐深度提升:增强后的模型(Llama-2-7B-Chat-Augmented)在有害内容上的KL散度,从“仅前几个token高”延伸到后续token(图4),证明对齐覆盖了更多token。

- 效用保留:AlpacaEval胜率从原模型的51.8%降至49.5%,仅轻微下降,说明安全增强未损害效用。

- 抗攻击能力提升:对推理阶段的三类攻击,ASR均大幅下降(表2):

- 预填充10个有害token的ASR:从51.5%→2.9%;

- GCG攻击ASR(HEx-PHI):从36.5%→18.4%;

- 解码参数攻击ASR(MaliciousInstruct):从84.3%→1.0%。

4.2 方案2:约束初始token——抵御微调攻击

核心思路:既然浅层对齐的脆弱性源于“初始token易被微调改变”,则通过逐token约束的微调目标,强制初始token的生成分布不偏离对齐状态,同时允许后续token为适配任务更新。

实现细节

-

约束目标设计:借鉴DPO和KTO的思路,设计带token级正则的微调目标,通过参数$\beta_t$控制不同token的约束强度:

$$

\min_{\theta} \mathbb{E}{(x,y)\sim D} \left[ -\sum{t=1}^{|y|} \frac{2}{\beta_t} \log \sigma\left( \beta_t \cdot \log \frac{\pi_{\theta}(y_t | x, y_{<t})}{\pi_{aligned}(y_t | x, y_{<t})} \right) \right]

$$- $\sigma$:sigmoid函数,用于平滑约束;

- $\beta_t$:约束强度——对前5个token设大$\beta_t$(如$\beta_1=0.5$,$\beta_{2-5}=2$),强制其分布接近对齐模型;对后续token设小$\beta_t=0.1$,允许适配任务。

-

梯度特性:初始微调时,模型参数与对齐模型一致,梯度与普通SFT相同;当初始token分布开始偏离时,(\beta_t)会自适应降低梯度权重,阻止进一步偏离。

实验效果

- 抗微调攻击能力:对三类微调攻击(有害微调、身份转移、后门投毒),约束模型的ASR远低于普通SFT(表3):

- 有害微调ASR:普通SFT 88.9% → 约束SFT 4.6%;

- 后门投毒(触发时)ASR:普通SFT 90.9% → 约束SFT 10.9%。

- 良性微调效用保留:在Samsum(摘要)、SQL生成、GSM8k(数学)任务上,约束SFT的效用(ROUGE-1、准确率)与普通SFT接近(如SQL生成准确率:普通SFT 99.1% → 约束SFT 98.5%)。

消融实验验证

- 偏置约束初始token至关重要:若对所有token用统一(\beta_t=0.1),约束失效(有害微调ASR 86.2%);若用统一(\beta_t=2.0),效用崩溃(SQL生成准确率92.6%);仅偏置初始token的约束最优。

- 热身步骤必要:前10步学习率热身可避免初始梯度过大破坏对齐,无热身时有害微调ASR升至29.1%,有热身时仅4.6%。

五、相关工作与结论

5.1 相关工作关联

- 表面对齐假说(SAH):此前研究提出“对齐仅改变输入输出格式”,本文进一步聚焦“安全领域的token级浅层性”,并解释了多种漏洞的共同根源。

- 逐token对齐效应:已有研究发现对齐对token的影响不均,但本文首次将其与“安全脆弱性”直接关联,并提出可落地的解决方案。

- 控制理论与安全RL:论文的“安全恢复示例”借鉴了“恢复策略(Recovery Policies)”思想,为后续结合安全RL深化对齐提供方向。

5.2 核心结论与启示

- 核心发现:当前LLM的安全对齐普遍是“浅层”的,仅依赖前几个token的拒绝前缀,这是多种越狱攻击的共同根源。

- 解决方案有效性:

- 数据增强可将对齐延伸到更多token,提升抗推理攻击能力;

- 约束初始token可抵御微调攻击,同时保留任务适配能力。

- 未来方向:安全对齐需突破“前几个token”的局限,探索结合控制理论、安全RL的深层对齐方法,确保对齐效果覆盖整个输出序列。

六、关键实验补充说明

- 模型与基准:实验用Llama-2-7B(Chat)、Gemma-7B(IT),安全评估以HEx-PHI为主,补充AdvBench(GCG攻击)、MaliciousInstruct(解码参数攻击)。

- 评估方法:用GPT-4-Turbo作为裁判,输出有害性评分(1-5分),ASR定义为“评分为5的样本比例”,确保客观性。

- 代码开源:实验代码已开源(https://github.com/Unispac/shallow-vs-deep-alignment),可复现关键结果。